Das neue KI-System OK-Robot soll es verschiedensten Robotern ermöglichen, auch in fremden Wohnungen aufzuräumen und beispielsweise herumliegende Wäschestücke oder Spielzeug vom Boden aufzunehmen und an anderer Stelle wieder abzulegen. Andere Robotersysteme hingegen werden in der Regel für den Einsatz in einer ihnen vertrauten Umgebung entwickelt.

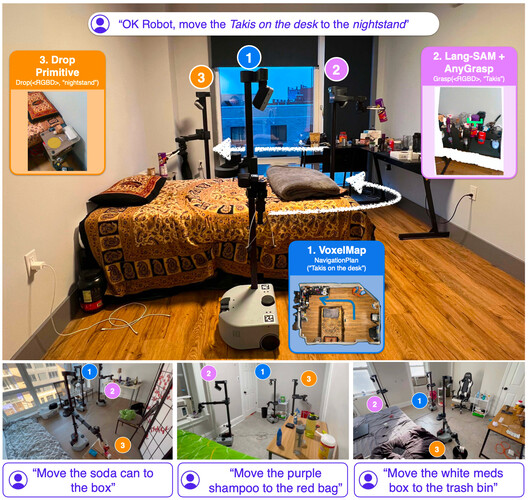

OK-Robot arbeitet mit VLMs (Vision-Language Models), einer Art KI-System, das Informationen aus Text oder direkter Sprache und Bildern gleichzeitig verarbeiten und verstehen kann. Interessant ist auch, dass OK-Robot mit verschiedenen Open-Source-KI-Modellen arbeitet und mit großen, öffentlich zugänglichen Datensätzen vortrainiert wurde.

Positiv ist, dass man dem Roboter keine zusätzlichen Trainingsdaten in der Umgebung geben muss, er funktioniert einfach. Die Kehrseite der Medaille ist, dass er nur einen Gegenstand aufnehmen und ihn an einem anderen Ort ablegen kann. Man kann ihn nicht bitten, eine Schublade zu öffnen, weil er nur diese beiden Dinge kann.

- Lerrel Pinto, Assistenzprofessor für Informatik an der New York University, der das Projekt mitleitete

Das System wurde von Forschern der New York University und Meta mit dem handelsüblichen Roboter Stretch der Firma Hello Robot in verschiedenen Wohnungen getestet, in denen 171 Pick-and-Drop-Experimente durchgeführt wurden.

Während der Experimente scannte der Roboter die Umgebung mit der iPhone-App Record3D, um ein 3D-Video zu erstellen, woraufhin das OK-Robot-System unter anderem ein KI-Objekterkennungsmodell über die Einzelbilder des Videos laufen ließ.

So konnte der Roboter alle Gegenstände in seiner Umgebung wie Tische, Sofas, Gläser, Schuhe oder Lampen identifizieren. Anschließend wurde er angewiesen, bestimmte Dinge aufzuheben, was ihm in 82,2 Prozent der Fälle gelang, sofern der Raum nicht zu unordentlich war. In chaotischeren Räumen sank die Erfolgsquote jedoch deutlich.

Ich würde sagen, dass es ziemlich ungewöhnlich ist, sich vollständig auf Standardmodelle zu verlassen, und dass es sehr beeindruckend ist, sie zum Laufen zu bringen. Wir haben eine Revolution im Bereich des maschinellen Lernens erlebt, die es ermöglicht hat, Modelle zu erstellen, die nicht nur im Labor, sondern auch in der freien Natur funktionieren. Zu sehen, dass dies tatsächlich in einer realen Umgebung funktioniert, ist eine sehr nützliche Information.

- Matthias Minderer, ein leitender Wissenschaftler für Bildverarbeitung bei Google DeepMind, der nicht an dem Projekt beteiligt war

Das System ist noch weit von Perfektion entfernt und hat beispielsweise gelegentlich Schwierigkeiten, Spracheingaben zu verstehen, und auch sein Greifmodell versagt bei einigen Gegenständen. Dennoch zeigt das Projekt, dass aktuelle Modelle relativ gut mit einem offenen Vokabular umgehen können und gleichzeitig in der Lage sind, die richtigen Objekte in unbekannten Räumen direkt anzusteuern.

Quelle(n)

MIT Technology Review | VentureBeat | Teaserbild: Symbolbild: DALL-E / AI | Bild 2,3: arvix