Ingenieure des Stanford Computational Imaging Lab haben einen Prototyp für eine leichte AR-Brille entwickelt, die den Weg für künftige holografische AR-Brillen ebnet, die wesentlich leichter sein werden als die derzeit erhältlichen. Der Schlüssel zu dieser Innovation ist ein KI-gesteuertes Display, das ein 3D-Bild ohne sperrige Linsen durch zwei Metaoberflächen in einem dünnen optischen Wellenleiter projiziert.

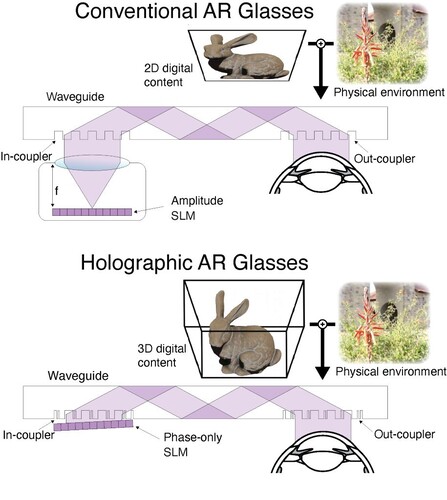

Herkömmliche AR/VR/XR-Headsets verwenden in der Regel Fokussierlinsen, um Mikro-LED- oder OLED-Displays auf die Augen des Trägers zu werfen. Leider führt die für die Linsen erforderliche Tiefe zu sperrigen Designs, wie z. B. bei Smartphones in Google Cardboard-Halterungen oder Apple Vision Pro-Headsets, die mehr als 600 Gramm wiegen.

Dünnere Designs verwenden manchmal einen optischen Wellenleiter (den man sich wie ein Periskop vorstellen kann), um das Display und die Linsen von vor den Augen an die Seite des Kopfes zu verlagern. Dadurch ist der Gebrauch jedoch auf 2D-Bilder und Text beschränkt. Die Stanford-Ingenieure haben nun KI-Technologie mit Metasurface-Wellenleitern kombiniert, um das Gewicht und die Abmessungen des AR-Headsets zu reduzieren und gleichzeitig ein holografisches 3D-Bild zu projizieren.

Die erste Innovation ist der Verzicht auf sperrige Fokussierlinsen. Stattdessen kodieren und dekodieren hauchdünne, in den Wellenleiter geätzte Meta-Oberflächen das projizierte Bild, indem sie das Licht beugen und lenken. Man kann sich das so vorstellen, als würde man an einem Ende eines Schwimmbeckens Wasser in einem bestimmten Rhythmus einspritzen. Wenn die Wellen das andere Ende erreichen, kann man sie auslesen, um den ursprünglichen Rhythmus wiederherzustellen. Die Stanford-Brille verwendet ein Metasurface vor dem Display und eine weiteres vor dem Auge.

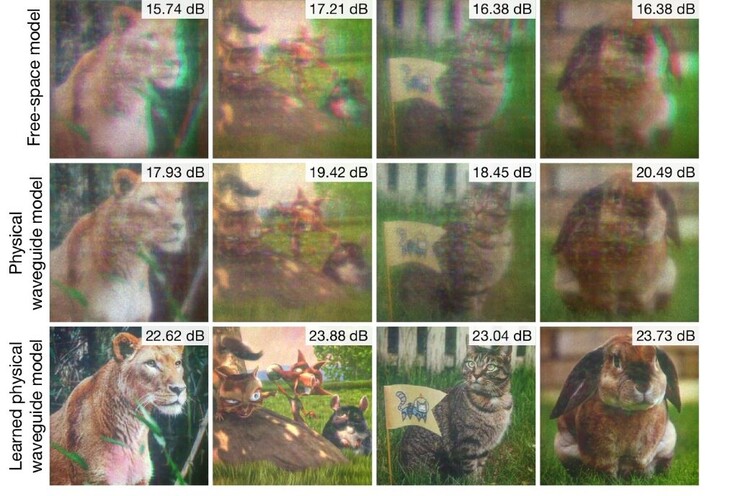

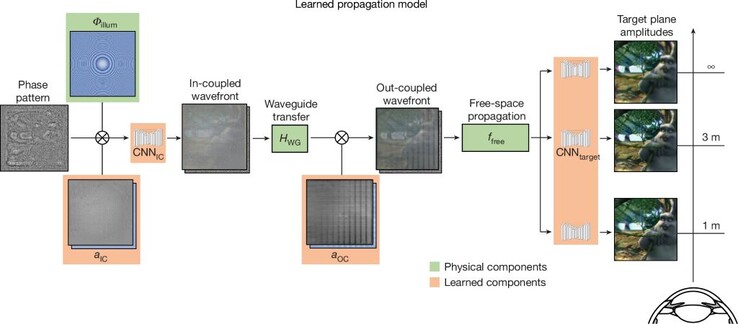

Die zweite Neuerung ist ein Wellenleiter-Ausbreitungsmodell, das simuliert, wie das Licht durch den Wellenleiter läuft, um holografische Bilder präzise zu erzeugen. 3D-Hologramme hängen in hohem Maße von der Genauigkeit der Lichtübertragung ab, und selbst Abweichungen im Nanometerbereich auf der Oberfläche des Wellenleiters können das sichtbare holografische Bild stark verändern. Hier werden mittels Deep-Learning neuronale Faltungsnetzwerke mit einer modifizierten UNet-Architektur auf rotes, grünes und blaues Licht trainiert, das durch den Wellenleiter geschickt wird, um die optischen Aberrationen im System zu kompensieren. Dies ist vergleichbar mit einem Pfeil, der zwar ins Schwarze trifft, aber ein winziges Stück nach rechts - jetzt weiß man, dass man das ausgleichen muss, indem man ein winziges Stück nach links zielt.

Die dritte Methode ist die Verwendung eines neuronalen KI-Netzwerks, um holografische Bilder zu erzeugen. Eine 48 GB Nvidia RTX A6000 wurde verwendet, um die KI auf eine Vielzahl von Phasenmustern zu trainieren, die von einem Holoeye Leto-3 Single-Phase SLM-Displaymodul projiziert wurden. Mit der Zeit lernte die KI, welche Muster bestimmte Bilder in vier Entfernungen (1 m, 1,5 m, 3 m und unendlich) erzeugen können.