Aus schnell wird schneller mit Nvidias KI Boost

Mehr drin mit Team Green!

TFLOPS, Stable Diffusion, maschinelles Lernen und natürlich die künstliche Intelligenz an sich. Die Tech Welt hat seit geraumer Zeit ein neues Lieblingsthema. Während die Konkurrenz aber noch mit Webcamfiltern wirbt, bietet Nvidia bereits mit der aktuellen mobilen GPU Generation die entsprechende Performance für "echte" Andwendungen. Lohnt sich also die dedizierte GPU im Notebook?(Anzeige) Veröffentlicht am 🇺🇸

Was kann die KI Ende 2024?

Die KI, die künstliche Intelligenz, ist seit dem letzten Jahr nicht mehr aus dem Tech Bereich wegzudenken und mittlerweile auch im Bewusstsein des Mainstreams angekommen.

Es wird über TFLOPS gesprochen, NPUs und wie sehr die neue Technik die Interaktion mit unseren Gadgets verändern wird.

Wir haben uns daher zusammen mit NVIDIA der Aufgabe gestellt uns einige Benchmarks anzuschauen. Die sind zwar zum Großteil synthetischer Natur, aber die Grundlage bilden immer “richtige” Anwendungen und während bei der Konkurrenz noch darüber gestritten wird, wer die schnellste NPU oder integrierte GPU für KI-beschleunigte Applikationen zum tragen bringt, bieten Nvidias Grafikchips bereits heute ein vielfaches an Leistung. Dank weitreichendem Software Support, übersetzt sich die theoretische Performance auch hervorragend in die Praxis sowohl für neue Techniken als auch für “klassische” GPU-beschleunigte Szenarien.

Asus ROG Zephyrus G16 - unser Referenzsystem

Für unsere heutigen Tests steht uns Asus ROG's neuester Spross aus der Zephyrus Familie als Referenzsystem zur Verfügung. Das schlanke Notebook setzt bei den Kernkomponenten auf Nvidia's mobile obere Mittelklasse, die RTX 4070 Laptop mit ihren 8GB VRAM. Der GPU zur Seite steht der Ryzen AI 370HX, AMD's neuestem 12-Kerner für Notebooks, gepaart mit verlöteten, aber schnellen 32 GB RAM.

Der Strixpoint Prozessor (mit 50 AITops und bereit für Copilot) bietet mit seiner integrierten RX 890m auch den perfekten Vergleich zur dedizierten Grafiklösung, immerhin handelt es sich hier um eine der schnellsten iGPUs Ende 2024.

Gaming - mehr FPS auf Knopfdruck

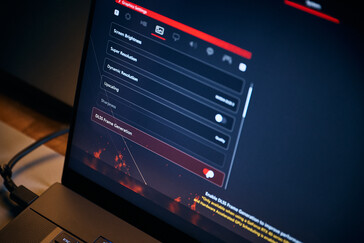

Nvidias KI-Wunderwaffe - Upscaling mit DLSS

Gamer sind erstaunlicherweise die bisher größte Gruppe die bereits seit der RTX 2000 Generation auf KI-Beschleunigung zurückgreifen können. Mit der Einführung von DLSS, bietet Nvidia seit mehreren Jahren die Möglichkeit, einzelne Frames in niedrigerer Auflösung zu rendern und durch einen Upscaler auf die gewünschte Zielauflösung zu bringen.

Fast forward ins Jahr 2024 und wir bekommen nicht nur höhere Framerates, sondern in den meisten Fällen auch ein besseres Bild, als mit nativen Renderingszenarien. Mithilfe von Supercomputern werden die entsprechenden Modelle in Renderfarmen trainiert und die dedizierten Lösungen, wie unsere RTX 4070 laptop im G16 ist für die lokale Anwendung zuständig.

Noch einen schritt weiter geht Frame Generation, und hier können aus dem vorangegangem Frame, Engineinformationen und Nvidias hauseigenen KI Modellen komplette Frames “generiert” werden. In der Kombination aus beiden Techniken ist in unterstützten Spielen ein enormer FPS Gewinn möglich, ohne mehr Strom zu verbrauen, ohne lautere Lüfter und ohne höhere Temperaturen.

CD Project Reds Cyberpunk 2077 ist vollgepackt mit den allerneuesten Grafiktechnologien, schaut toll aus und benötigt einiges an Leistung um die gebotene Bildqualität einigermaßen flüssig auf den Bildschirm zu bringen. Selbst unsere RTX 4070 kommt hier an ihre Grenzen, während die 890m bei aktiviertem Raytracing in der nativen Auflösung schlicht und ergreifend keine Chance hat.

Aber selbst im Falle der dedizierten Lösung zeigt sich das mehr Rohleistung, wenn sowohl Abwärme als auch der Energieverbrauch die einschränkenden Faktoren sind, nicht die Lösung ist und es hier nach einem neuen Ansatz verlangt, wenn wir in Zukunft noch schönere Spiele haben wollen.

Mit DLSS und Frame Generation zeigt sich aber eindrucksvoll was mit den GPU-gestützten KI-Helfern möglich ist, und was erst unspielbar war, wandelt sich in ein flüssiges Spielerlebnis. Die praktischen KI-Helfer erfreuen sich auch wachsender Beliebheit auf der Seite der Spiele-Entwickler und so wird DLSS in mittlerweile 600 Spielen unterstützt und Frame Generation in bereits mehr 130 Titeln ... Tendenz steigend!

| Cyberpunk 2077 | 2560 x 1600p Raytracing Ultra Preset | + DLSS Balanced | + DLSS Balanced / + Frame Generation |

|---|---|---|---|

| Nvidia RTX 4070 Laptop | 22.31 fps (min: 18.5/max: 26.8) | 44.59 fps (min: 38/max:51.5) | 73.38 fps (min: 65.7/max:81.7) |

| AMD RX 890m | 3.11 fps (min: 2.4/max: 4.3) | - | - |

Die PC-Fassung von Final Fantasy XVI bietet zwar kein Raytracing, aber auch in diesem Fall ist die magische 60 fps Grenze in den höchsten Einstellung mit traditionellen Rendermethoden in weiter Ferne und während hier bereits DLSS allein reichen würde, gibt es mit den "künstlich" generierten Zwischenframes die Extraportion Smoothness über die sich wohl jeder Gamer freuen wird.

| Final Fantasy XVI | |

| Asus ROG Zephyrus G16 GA605WI | |

| 2560x1440 Ultra Preset (Super Resolution off) | |

| 2560x1440 Ultra Preset + Quality DLSS | |

| 2560x1440 Ultra Preset + Quality DLSS FG | |

Mit Dragon Age: The Veilguard bietet auch Bioware wieder ein immersives Rollenspiel und neben dem klassischen Storytelling kommen im neuesten Teil auch Raytracing für realistische Beleuchtung, korrekte Schatten und glaubhafte Reflexionen zum Einsatz. In der nativen Auflösung, mit den höchsten Einstellungen und mit aktiviertem Raytracing fehlen wieder einige frames für ein flüssiges Spielerlebnis und hier schaffen DLSS und Frame Generation erneut eindrucksvoll Abhilfe.

| Dragon Age: Veilguard | 2560 x 1600p Ultra Settings + RT | + DLSS Quality | + DLSS Quality / + Frame Generation |

|---|---|---|---|

| Nvidia RTX 4070 Laptop | 38 fps | 52 fps | 76 fps |

Schnell und Schön - Ray Reconstruction für eine klare Darstellung

Aber nicht nur die Performance, sondern natürlich auch die Bildqualität sollte in modernen AAA-Titeln nicht zu kurz kommen und hier hat vor allem Ray Tracing in den letzten Jahren enorme Fortschritte gemacht.

Der Einsatz der realistisch und physikalisch korrekt berechneten Lichtstrahlen erfordert neben den entsprechenden Leistung auch den Einsatz sogenannter “Denoiser”.

Da nicht alle erforderlichen Strahlen für einen kompletten Frame berechnet werden können müssen die fehlenden Informationen künstlich "aufgefüllt" werden, was häufig eine feine Körnung, das sogenannte Bildrauschen und reduzierte Details zur Folge hat.

Nvidia bietet mit Ray Reconstruction, eine KI unterstützte Möglichkeit dieses Rauschen zu entfernen oder zu reduzieren mit enormen Vorteilen bei der Bildqualität und dem effizienteren Einsatz für Developer, gegenüber klassischen “handgebauten” Denoisern

Klare Reflexionen, realistische Schatten und das Extra an Realismus, dank Ray Reconstruction und Pathtracing.

Natürlich bietet nicht nur Cyberpunk die neue Technik, und wir haben uns auf unserem YouTube Kanal Remedy's Alan Wake II näher angeschaut. Das Adventure bietet neben der packenden Story nämlich ebenso Pathtracing und Ray Reconstruction und ist ebenfalls eines der schönsten Spiele der aktuellen Generation.

Content Creation - pure Leistung und moderne Features für Kreative

Neben der virtuellen Unterhaltung bieten Nvidia GPUs vor allem auch bei der Arbeit enorme Vorteil mit der Kombination aus der entsprechenden Hardware in der Form von CUDA-, RT-, und Tensorcores und dem weitreichenden Softwaresupport in gängigen Kreativapps.

Bildgeneration mit Stable Diffusion

Als synthetische Grundlage starten wir mit UL Procyon, einer modernen Benchmark Suite die mit kurzen Tests eine generelle Einordnung der Leistung erlaubt und die Vorteile der dedizierten Grafiklösungen zeigen sich deutlich in unseren Ergebnissen.

Stable Diffusion kann bei der Bildgeneration direkt auf die Tensor Kerne der RTX 4070 zurückgreifen, welche speziell für KI Anwendungen optimiert wurden und im Vergleich zur integrierten 890m ist der Vorsprung auch nicht von der Hand zu weisen und gerade für die iterative Arbeit ist der Geschwindigkeitsvorsprung gern gesehen.

Unser Referenzsystem, das ROG Zephyrus G16 zeigt zudem eindrucksvoll, das die gebotene Leistung nicht immer mit einem großen, schweren und unhandlichen Formfaktor einhergeht.

| UL Procyon for Windows | |

| Image Generation Stable Diffusion 1.5 (FP16) | |

| Asus ROG Zephyrus G16 GA605WI | |

| Asus ROG Zephyrus G16 GA605WI | |

| Overall Image generation Speed | |

| Asus ROG Zephyrus G16 GA605WI | |

| Asus ROG Zephyrus G16 GA605WI | |

* ... kleinere Werte sind besser

Blender - RT-Kerne FTW!

Die künstliche Intelligenz mag zur Zeit das Buzzword schlechthin der Tech Welt sein, aber selbst in traditionelleren Anwendungen ist das Thema GPU-Beschleunigung wichtiger denn je. Vorallem in CGI-Applikationen, wenn also 3D Modelle, Texturen oder ganze Welten künstlich erzeugt werden, läuft ein Großteil der entsprechenden Berechnungen auf der Grafikkarte.

Die RT-Kerne der aktuellen 4000er Generation beschleunigen dabei nicht nur Raytracing in Spielen, sondern auch auf der anderen Seite, wie zum Beispiel in dem Open-Source Tool Blender.

In unseren Standard Benchmarks ist der Classroom Test seit geraumer Zeit nicht mehr wegzudenken und in unserer Datenbank füllen die dedizierten Lösungen von Nvidia seit geraumer Zeit die Spitzenpositionen. In der neuesten Version 4.2 benötigt die 4070 nur wenige Sekunden für den Testframe während sowohl auf der 890m oder mit dem klassischen CPU-Rendering mehrere Minuten benötigt werden.

| Render Engine | Dauer |

|---|---|

| Nvidia RTX 4070 Laptop | 0 min 20s |

| AMD RX 890m | 3 min 35s |

| AMD Ryzen 370 HX | 4 min 25s |

Davinci Resolve 19 - Handwerk meets KI

Für unseren YouTube Kanal setzen wir bei der Produktion auf Davinci Resolve aus dem Hause BlackMagic und in den vergangenen zwei Jahren haben auch in dem professionellen Schnitt und Color-Grading Programm immer mehr KI-Tools Einzug gehalten. Neben praktischen Transkriptionsoptionen, Upscalern, automatischer HDR Konvertierung kann selbst die Bildrate ganzer Clips neu berechnet werden und auch hier kommen wieder verstärkt die Tensor Kerne der Nvidia GPUs zum Einsatz.

Um die entsprechende Leistung zu vergleichen haben wir auf den entsprechenden Benchmark der Experten von Puget Bench in der Extended Version zurückgegriffen in dem vor allem auch die KI-Leistung getestet wird. Die 890m ist leider nicht in der Lage den Test zu vollenden, weshalb wir zusätzlich noch den Basic Test durchgeführt haben um einen Vergleich zu ermöglichen.

Auf unserem YouTube Kanal bieten wir auch einen Blick hinter die Kulissen und beleuchten wie wir unsere Videos im Detail bearbeiten und welchen Unterschied vor allem auch die KI-Funktionen in Resolve im Alltag tatsächlich machen.

| DaVinci Resolve PugetBench | |

| Extended Score 1.1 | |

| Asus ROG Zephyrus G16 GA605WI | |

| Basic Score 1.1 | |

| Asus ROG Zephyrus G16 GA605WI | |

| Asus ROG Zephyrus G16 GA605WI | |

| AI Score (Extended) | |

| Asus ROG Zephyrus G16 GA605WI | |

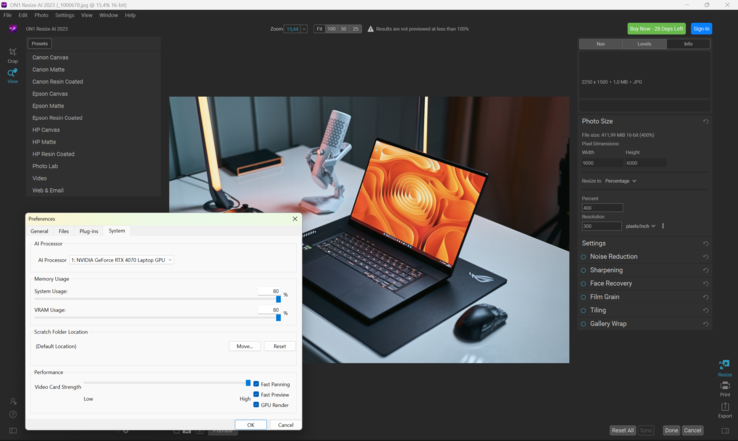

ON1 - einmal in Groß, bitte!

Als letztes Beispiel für praktische KI Anwendungen schauen wir uns noch die Upscale-Lösung für Fotos von ON1 an. Als Einzelanwendung oder als Plug-In für Industrie Standards wie Photoshop, bieten die Vergrößerungsspezialisten allerhand Einstellmöglichkeiten um Bilder großzurechnen. Wir haben anhand von 5 Beispielbildern getestet was für Rechenleistung für eine Vergrößerung von 200% benötigt wird und ob die Wartezeit für einen Espresso reicht.

Während bei der RTX 4070 wahrescheinlich noch nicht einmal die Bohnen gemahlen sind, bietet die 890m etwas mehr Spielraum, während es bei der CPU-Berechnung für eine ganze Kaffeepause reicht.

| Render Engine | Dauer |

|---|---|

| Nvidia RTX 4070 Laptop | 52s |

| AMD RX 890m | 182s |

| AMD Ryzen 370 HX | 2059s |

Fazit - Software und Hardware im Einklag

KI ist mittlerweile überall und wird zugegebenermaßen auch enorm inflaionär verwendet und gerade im Tech Bereich ist es mittlerweile sehr schwer geworden anhand handfester Ergebnisse zu bestimmen was moderne Prozessoren und Grafikkarten leisten können. Während dedizierte GPUs natürlich immer einen Leistungsvorteil gegenüber integierten Lösungen haben werden, ist in den letzten Jahren auch der Energiebedarf deutlich gesunken bei um ein vielfaches besserer Leistung. Somit gibt es mittlerweile Notebooks mit Nvidia GPUs in extrem kompakten Gehäusen die früher nur deutlich weniger potenten Laptops vorbehalten waren.

Das G16 ist das perfekte Beispiel für diesen Trend und bietet mit der RTX 4070 Spiele-Performance die in der Lage ist den QHD+ Bildschirm in aktuellen AAA-Titel mit maximalen Details und modernen Raytracing Effekten zu befeuern und Anwendungsleistung, die aus dem schlanken 16 Zoller eine mobile Workstation machen.

KI-Funktionen sind dabei tief in Nvidias Hardware und die Software integiert und somit vervielfachen Technologien wie DLSS und Frame Generation die Framerates unserer Games und verkürzen die Wartezeiten bei der Arbeit.

Und gerade die Implementierung dieser Funktionen und der Support auf der Software Seite gewährt Nvidia ein konkurrenzloses Alleinstellungsmerkmal bei der Suche nach dem (fast) perfekten Laptop.

Transparenz

Beim vorliegenden Artikel handelt es sich um eine entgeltliche Einschaltung. Alle Inhalte wurden vom Werber bereitgestellt.