Apple hat bereits vor Monaten mehrere neue Features angekündigt, die verhindern sollten, dass Kinderpornographie verbreitet wird. Der sogenannte CSAM-Scan, der in den Foto-Bibliotheken von iPhone- und iPad-Nutzern nach Child Sexual Abuse Material, also nach sexuell expliziten Bildern von Kindern sucht, kam bei Kunden alles andere als gut an, nachdem diese berechtigte Sorgen über massive Eingriffe in ihre Privatsphäre geäußert haben.

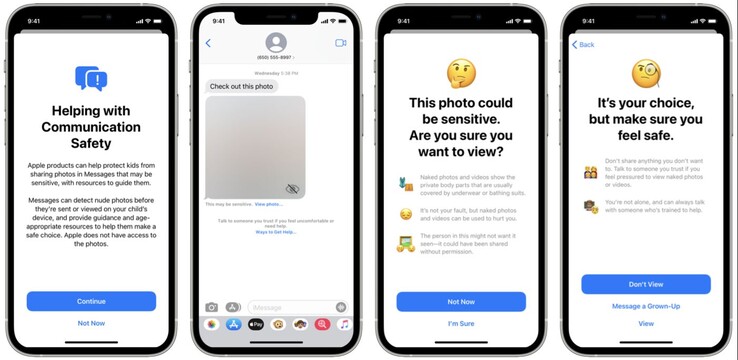

Darauf hin hat Apple den Launch dieses Features auf unbestimmte Zeit verschoben. Wie Bloomberg nun berichtet soll aber eines der anderen angekündigten Features mit dem Update auf iOS 15.2 in Kürze starten, nämlich die Nacktbild-Erkennung in der Nachrichten-App. Wenn das iPhone, das iPad oder der Mac eines Kindes eine Nachricht mit einem Bild empfängt oder aber ein Bild verschickt wird, so wird dieses analysiert, um zu erkennen, ob es sich dabei um ein sexuell explizites Foto handelt.

Falls dem so ist wird es unscharf dargestellt. Nutzer können anschließend entscheiden, ob sie das Bild dennoch anzeigen möchten, oder ob sie ihre Eltern informieren möchten. Anders als zuvor angekündigt werden die Eltern nicht mehr automatisch benachrichtigt. Damit Bilder überhaupt gescannt werden, müssen Eltern dieses Feature in den Einstellungen der Familienfreigabe aktivieren.

Da die Analyse der Bilder lokal auf dem Gerät ausgeführt wird und da das Feature manuell aktiviert werden muss dürfte diese Funktion die Privatsphäre von Nutzern nicht maßgeblich beeinträchtigen, es bleibt aber abzuwarten, wie Apple seine Pläne zu den CSAM-Scans künftig weiter vorantreiben wird.