Es ist vor allem der Datentransfer, der einen Großteil des Energieverbrauchs verursacht. Bei den enormen Datenmengen, mit denen die Algorithmen künstlicher Intelligenz arbeiten, gilt das noch mehr.

Diesen Schritt auszulassen, der zudem als Flaschenhals zwischen Speicher und logischen Prozessen gilt, hat somit einen enormen Einfluss. Und genau hier kommt eine Idee aus dem Jahr 2003 ins Spiel, die schon damals an der University of Minnesota entwickelt wurde.

Die hat zu einer Zusammenarbeit zahlreicher Disziplinen von Physik über Ingenieurwesen bis Computerwissenschaften geführt. Heraus kamen bereits einige Schaltungen, die heute in Smart Watches und Speicherelementen zum Einsatz kommen.

Und ebenfalls dabei war Computational Random Access Memory, also CRAM. Dieser erlaubt das tatsächliche Berechnen sowie die Ausführung paralleler Prozesse direkt im Arbeitsspeicher und dort an jeder beliebigen Stelle.

Mehr als eine neue Architektur

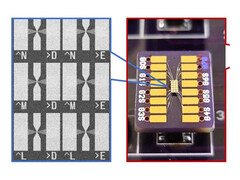

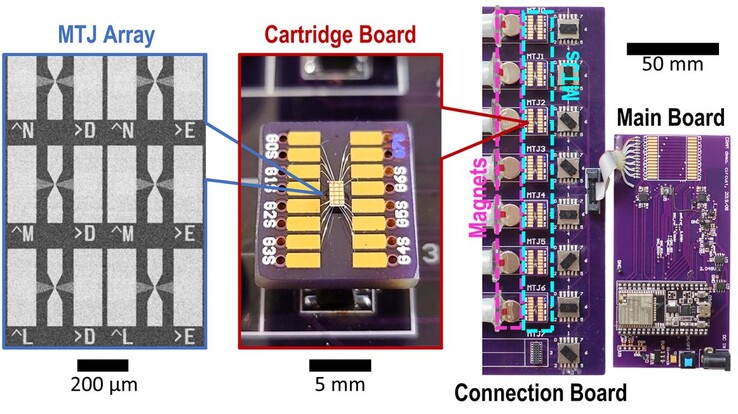

Darüber hinaus handelt es sich nicht um klassische Schaltungen, sondern um magnetische Tunnelkontakte, welche statt der Ladung den Elektronenspin für den Wechsel zwischen 0 und 1 verwenden können.

So ergibt sich bei Anwendungen auf Basis künstlicher Intelligenz ein Stromverbrauch von einem Tausendstel, um schlussendlich zum gleichen Ergebnis zu kommen wie mit der klassischen Methode. Wie riesig diese Menge an Strom ist, zeigt der derzeitige und prognostizierte Stromverbrauch neuronaler Netze weltweit. Bereits 2022 wurden laut Internationaler Energieagentur 460 Terawattstunden benötigt. Spätestens 2026 sollen es 1.000 Terawattstunden sein.

Mit dem gigantischen Sparpotential von 99,9 Prozent blieben also 999 Terawattstunden, die nicht mehr nötig wären. Das entspricht dem jährlichen Stromverbrauch von Japan, der viertgrößten Volkswirtschaft mit 126 Millionen Einwohnern.

Laut dem Paper wäre das noch nicht einmal das bestmögliche Ergebnis. Weitere Versuche konnten den Energieverbrauch um den Faktor 1.700 beziehungsweise 2.500 absenken. Ermöglicht wird diese zusätzliche Effizienzsteigerung durch eine gezielte Anpassung des CRAM an einzelne Algorithmen, die dadurch noch schneller und somit sparsamer berechnet werden können.